Im Januar 2020 hat Facebook neue Tools vorgestellt, die Community-Management deutlich transparenter machen und es erlauben, die Facebook-Community-Standards um eigene Regeln zu erweitern.

Die neuen Tools sind aktuell im Test für Live-Events im Gaming-Bereich, leider. Denn wenn man sich die Funktionen einmal genauer anschaut, sind sie eine Steilvorlage die besseres Community-Management für alle erlauben würde. Viele unnötige Umwege würden wegfallen und als Moderator/Administrator gäbe es einen einfachen und genauso transparenten Weg mit den Problemen in der Community umzugehen.

Das neue Toolkit im Überblick

Die Funktion von Facebook besteht aus einer vorgegebenen Auswahl an Regeln, die über die normalen Community-Guidelines von Facebook hinaus gehen. Aktuell wird sowas meist in Form einer Netiquette in einer Notiz, einem gepinnten Beitrag in einer Gruppe oder in der Beschreibung einer Facebook-Seite angegeben. Diese zusätzlichen Regeln werden allerdings sehr schnell übersehen, was dann wieder in mehr Arbeit für die Moderatoren endet. In den Facebook-Gruppen gibt es hier noch die meisten Optionen dies klar zu machen, auf Seiten aber fast gar nicht.

Ingesamt gibt es vier neue Funktionen – die aber wie gesagt aktuell nur für Live-Streams in der Gaming-Community und nur für einen Testkreis zugänglich sind.

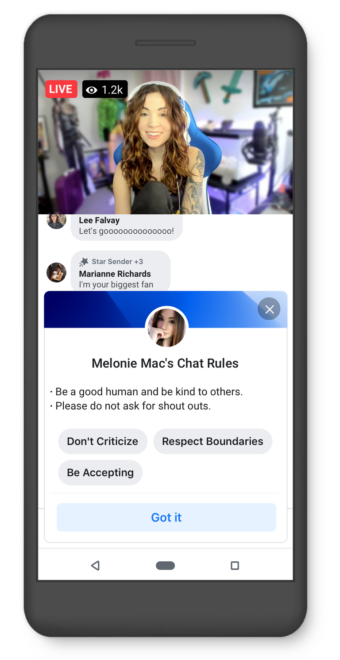

1. Klare Standards – Regeln müssen akzeptiert werden

Die zusätzlichen Regeln werden sehr offensiv dargestellt, jeder der einen Kommentar abgeben will, muss diesen zustimmen. So will Facebook sicherstellen, dass dies auch wirklich gelesen werden. Als Nutzer muss man nur einmal zustimmen und kann zukünftig in diesem Chat kommentieren.

2. Realtime Moderation

We’ve made comment removals happen in real time, so when a comment is removed or someone is banned, their comments will disappear from the stream immediately.

Das heißt ein Klick, alles weg, ohne Reload oder ähnliches bei den anderen Nutzern. So ist es zum Beispiel aktuell bei Facebook-Seiten. Wenn wir einen Kommentar löschen, jemand anders den Beitrag aber gerade schon aufgerufen hatte, ist dieser dort – bis zum Reload – sichtbar. Ist in der Praxis vor allem bei sehr sehr aktiven Diskussionen hilfreich.

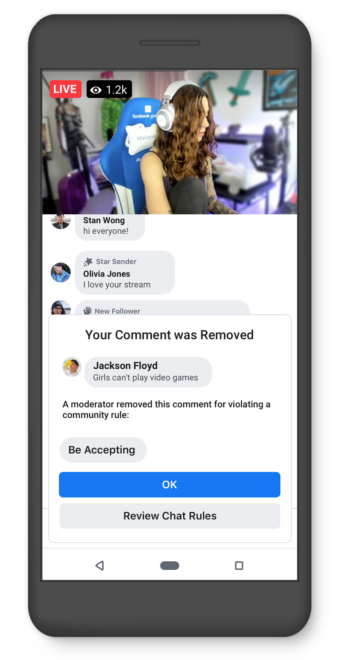

3. Transparente Moderation – Kontext für die Nutzer

Als Moderator kann man hier auswählen, warum ein Kommentar entfernt wurde und als Nutzer bekommt man Feedback darüber. Für beide Seiten ganz klar kommuniziert. Es gibt hier aber noch kein Freitextfeld für mehr Erklärungen, kann also auch für Missverständnisse sorgen.

4. Dashboard für Moderatoren

„In addition to these rules, moderators will now have access to a new moderation dashboard with resources to prevent harassment, protect their privacy and help ensure creators feel safe.“

Details zu diesem Dashboard kennen wir leider nicht.

Hintergrund – warum gibt es das Toolkit ausgerechnet für diesen Case?

Dazu überfliegt ihr am besten einmal kurz die Meldung von Facebook:

„We know creators come to Facebook to build positive and supportive communities around the games they love, so today we’re introducing new tools to help gaming creators foster inclusive environments.

While our Community Standards protect against the most egregious harms like hate speech and terrorism, sometimes all it takes is one person being rude, mean or simply disruptive to ruin a conversation for everyone. And what may be considered competitive banter in one streaming community, might be considered toxic in another. Gaming creators are tone setters, so that’s why we’re releasing a toolkit to help them set guidelines for positive conversations in their community.

We worked with the Fair Play Alliance, a coalition of game companies encouraging healthy communities in online gaming, and partnered directly with their Executive Steering Committee, to establish rules creators and moderators can use to set guidelines and help avoid disruptive comments.„

Fazit – warum nicht für alle?

Wir finden ja, dass diese Funktionen ein Vorbild sein könnte für die Moderation von Facebook-Seiten oder auch Gruppen, weil wir uns diese Transparenz schon lange wünschen. Am Beispiel von der Funktion 3 kann man dann klar kommunizieren, warum etwas auf dem eigenen Kanal unerwünscht ist. Aktuell verbirgt man einen Kommentar und die Nutzer bekommen das meist gar nicht mit und kennen vor allem den Grund auch nicht. Außer man schreibt nochmal zusätzlich etwas, was wieder sehr aufwendig werden kann.

Das darf man auch nicht damit verwechseln, dass ein Kommentar zum Beispiel wegen Hate-Speech offiziell bei Facebook gemeldet wird. Hier handelt es sich „nur“ um einen Verstoß innerhalb der Community.

Wir fänden es total cool. Aber ihr wisst ja:

„We’re testing these rules now with a small group of creators and we’ll roll them out globally in the coming months.“